ERP

Chuyên ngành

Tools/Apps

Công nghệ

Code riêng

Mỗi giây trôi qua, thế giới số tạo ra một khối lượng dữ liệu khổng lồ, theo Solvexia, trung bình 1,7 MB dữ liệu cho mỗi người dùng Internet mỗi giây. Tuy nhiên, nghịch lý nằm ở chỗ, phần lớn doanh nghiệp hiện nay chỉ dừng lại ở việc thu thập dữ liệu, trong khi giá trị thực sự của dữ liệu chỉ xuất hiện khi áp dụng cách xử lý dữ liệu, chuẩn hóa và phân tích một cách có hệ thống.

Khi dữ liệu còn ở trạng thái thô, nó không khác gì “tài nguyên chưa được khai thác”. Chỉ thông qua quy trình xử lý dữ liệu bài bản, doanh nghiệp mới có thể chuyển đổi dữ liệu thành insight có giá trị, làm cơ sở cho các quyết định chiến lược chính xác và kịp thời. Trong phần tiếp theo, chúng ta sẽ cùng phân tích cách xây dựng quy trình xử lý dữ liệu hiệu quả, giúp doanh nghiệp tối ưu hóa nguồn lực và khai thác trọn vẹn sức mạnh của dữ liệu.

Cách xử lý dữ liệu (Data Processing) là quá trình có hệ thống nhằm thu thập, chuẩn hóa, tổ chức và chuyển đổi dữ liệu thô thành thông tin có cấu trúc, đáng tin cậy và có giá trị sử dụng. Quá trình này bao gồm nhiều công đoạn then chốt như nhập liệu, kiểm tra tính hợp lệ, làm sạch, phân loại, tính toán, tổng hợp và xuất dữ liệu, tạo nền tảng cho hoạt động phân tích, báo cáo và ra quyết định chính xác trong toàn bộ hệ thống vận hành.

Về bản chất, dữ liệu thô thường rời rạc, thiếu nhất quán và khó khai thác trực tiếp. Cách xử lý dữ liệu đóng vai trò như một dây chuyền sản xuất thông minh, nơi dữ liệu đầu vào được tinh lọc và tái cấu trúc để trở thành thông tin có ý nghĩa, sẵn sàng phục vụ các mục tiêu kinh doanh, quản trị và nghiên cứu.

Tầm quan trọng của các cách xử lý dữ liệu trải dài trên hầu hết các lĩnh vực: từ tài chính – ngân hàng, y tế, sản xuất, thương mại điện tử cho đến nghiên cứu khoa học và quản trị doanh nghiệp. Trong mọi bối cảnh, chất lượng quyết định phụ thuộc trực tiếp vào chất lượng dữ liệu đã được xử lý. Dữ liệu sai lệch, thiếu chuẩn hóa hoặc không được kiểm soát sẽ dẫn đến những kết luận sai lầm và rủi ro vận hành nghiêm trọng.

Ngày nay, các cách xử lý dữ liệu không còn là năng lực dành riêng cho các vị trí kỹ thuật như quản trị cơ sở dữ liệu, kỹ sư dữ liệu hay nhà khoa học dữ liệu. Trong kỷ nguyên số và kinh tế dựa trên dữ liệu, hiểu và làm chủ các nguyên tắc xử lý dữ liệu cơ bản đã trở thành một kỹ năng nền tảng, giúp cá nhân và tổ chức khai thác hiệu quả tài nguyên dữ liệu, tối ưu quy trình và nâng cao năng lực cạnh tranh.

Nói cách khác, xử lý dữ liệu chính là cầu nối chiến lược giữa dữ liệu và tri thức, giữa thông tin và hành động, giữa vận hành hiện tại và quyết định tương lai.

Cách xử lý dữ liệu theo 6 bước chuẩn trong thực tiễn phân tích

Thu thập dữ liệu là nền móng của toàn bộ cách xử lý dữ liệu và phân tích. Ở giai đoạn này, dữ liệu thô được tiếp nhận từ nhiều nguồn khác nhau như hệ thống cảm biến, cơ sở dữ liệu nội bộ, phần mềm nghiệp vụ hoặc khảo sát khách hàng. Yêu cầu cốt lõi không chỉ nằm ở số lượng, mà quan trọng hơn là tính chính xác, tính đầy đủ và mức độ phù hợp với mục tiêu phân tích.

Một rủi ro thường gặp trong bước này là sai lệch chọn mẫu – khi phương pháp thu thập vô tình ưu tiên một nhóm dữ liệu nhất định, dẫn đến kết quả phân tích thiếu khách quan. Do đó, quy trình thu thập cần được thiết kế có kiểm soát, minh bạch và bám sát bài toán nghiệp vụ.

Sau khi thu thập, dữ liệu thô hiếm khi có thể sử dụng ngay. Giai đoạn chuẩn bị dữ liệu tập trung vào việc làm sạch, chuẩn hóa và cấu trúc lại dữ liệu để sẵn sàng cho xử lý chuyên sâu.

Các hoạt động phổ biến trong cách xử lý dữ liệu bao gồm phát hiện và xử lý lỗi, loại bỏ dữ liệu trùng lặp hoặc không hợp lệ, xử lý giá trị thiếu và chuẩn hóa định dạng. Ngoài ra, dữ liệu có thể được làm giàu bằng cách kết hợp thêm thông tin từ các nguồn bên ngoài nhằm tăng chiều sâu và giá trị phân tích. Mục tiêu cuối cùng là xây dựng một tập dữ liệu đáng tin cậy, nhất quán và phản ánh đúng thực tế vận hành.

Ở bước nhập dữ liệu, tập dữ liệu đã được chuẩn bị sẽ được đưa vào hệ thống xử lý trung tâm – có thể là phần mềm phân tích, nền tảng BI hoặc các thuật toán xử lý dữ liệu chuyên biệt. Quá trình này trong cách xử lý dữ liệu có thể diễn ra dưới nhiều hình thức như nhập thủ công, đồng bộ từ hệ thống bên thứ ba hoặc thu thập tự động theo thời gian thực.

Việc lựa chọn phương thức nhập dữ liệu phụ thuộc vào khối lượng dữ liệu, yêu cầu tốc độ xử lý và mức độ tự động hóa của tổ chức. Một hệ thống nhập dữ liệu hiệu quả sẽ giúp giảm thiểu lỗi phát sinh và đảm bảo tính liên tục của dòng dữ liệu.

Đây là giai đoạn cốt lõi, nơi dữ liệu được chuyển đổi thành thông tin có giá trị. Các kỹ thuật xử lý như lọc, sắp xếp, tổng hợp, phân loại hoặc biến đổi dữ liệu được áp dụng để làm nổi bật các mối quan hệ, xu hướng và quy luật tiềm ẩn.

Cách xử lý dữ liệu được lựa chọn cần bám sát mục tiêu phân tích – từ báo cáo mô tả, phân tích chẩn đoán cho đến dự báo và hỗ trợ ra quyết định. Một quy trình xử lý hiệu quả không chỉ tạo ra kết quả chính xác mà còn đảm bảo khả năng tái sử dụng và mở rộng trong tương lai.

Sau khi áp dụng cách xử lý dữ liệu, dữ liệu cần được trình bày dưới dạng dễ hiểu và có khả năng hành động. Điều này thường được thực hiện thông qua báo cáo, dashboard, biểu đồ hoặc các hình thức trực quan hóa dữ liệu giúp người dùng nhanh chóng nắm bắt thông tin cốt lõi.

Tuy nhiên, giá trị thực sự của cách xử lý dữ liệu này không nằm ở việc hiển thị dữ liệu, mà ở khả năng diễn giải đúng bối cảnh và rút ra insight. Việc phân tích kết quả cần gắn liền với mục tiêu kinh doanh, từ đó hỗ trợ ra quyết định dựa trên dữ liệu thay vì cảm tính.

Bước cuối cùng của cách xử lý dữ liệu là lưu trữ dữ liệu và kết quả xử lý vào cơ sở dữ liệu hoặc kho dữ liệu nhằm phục vụ cho việc truy xuất, phân tích hoặc tái sử dụng trong tương lai. Một chiến lược lưu trữ hiệu quả cần đảm bảo tính an toàn, khả năng mở rộng và tuân thủ các yêu cầu về bảo mật và quyền riêng tư dữ liệu.

Việc lưu trữ không chỉ là “cất dữ liệu đi”, mà còn là nền tảng để xây dựng hệ thống tri thức dài hạn, hỗ trợ phân tích lịch sử và ra quyết định chiến lược trong tổ chức.

Tổng hợp phương pháp xử lý dữ liệu và ứng dụng trong hệ thống số

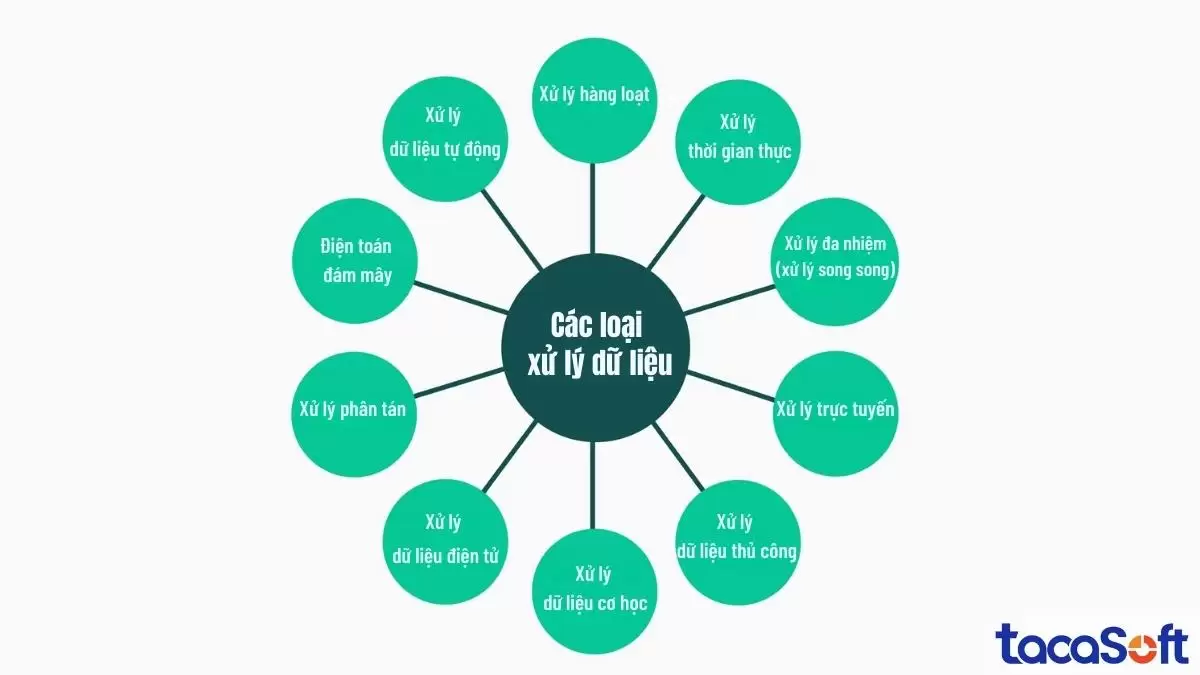

Cách xử lý dữ liệu là quá trình áp dụng các phương pháp, kỹ thuật và công nghệ khác nhau nhằm chuyển đổi dữ liệu thô thành thông tin có giá trị, phục vụ cho phân tích, ra quyết định và vận hành hệ thống. Tùy theo yêu cầu về thời gian, quy mô, độ phức tạp và mức độ tự động hóa, các phương pháp xử lý dữ liệu được phân thành nhiều loại khác nhau.

Cách xử lý dữ liệu theo lô là phương pháp xử lý dữ liệu theo từng nhóm lớn tại các thời điểm được xác định trước, thay vì xử lý ngay khi dữ liệu phát sinh. Cách tiếp cận này đặc biệt phù hợp với các tác vụ không yêu cầu phản hồi tức thì và có khối lượng dữ liệu lớn.

Bằng cách xử lý dữ liệu gom và xử lý trong các khung giờ thấp điểm, doanh nghiệp có thể tối ưu tài nguyên hệ thống, giảm tải cho hạ tầng và nâng cao hiệu quả vận hành tổng thể.

Ví dụ: Trong lĩnh vực tài chính – ngân hàng, các giao dịch như đối soát séc hoặc cập nhật số dư tài khoản thường được xử lý theo lô vào ban đêm nhằm đảm bảo độ chính xác và tính nhất quán của dữ liệu.

Xử lý thời gian thực cho phép hệ thống phân tích và phản hồi dữ liệu ngay tại thời điểm dữ liệu được tạo ra. Phương pháp này đóng vai trò then chốt trong các ứng dụng mà độ trễ dù rất nhỏ cũng có thể gây ra rủi ro hoặc làm giảm trải nghiệm người dùng.

Với xử lý thời gian thực, dữ liệu không chỉ được ghi nhận mà còn được phân tích và kích hoạt hành động gần như tức thì, hỗ trợ ra quyết định nhanh và chính xác.

Ví dụ cách xử lý dữ liệu: Hệ thống định vị GPS sử dụng xử lý thời gian thực để liên tục cập nhật vị trí, phân tích tình hình giao thông và đề xuất lộ trình tối ưu dựa trên điều kiện đường sá hiện tại.

Cách xử lý dữ liệu đa nhiệm, hay còn gọi là xử lý song song, là phương pháp phân chia một bài toán lớn thành nhiều tác vụ nhỏ và thực thi đồng thời trên nhiều bộ xử lý hoặc nhiều máy tính. Cách tiếp cận này giúp rút ngắn đáng kể thời gian xử lý và nâng cao hiệu suất đối với các tác vụ tính toán phức tạp.

Đây là nền tảng của các hệ thống hiệu năng cao (High Performance Computing – HPC) và các ứng dụng yêu cầu xử lý khối lượng dữ liệu lớn.

Ví dụ cách xử lý dữ liệu: Trong ngành công nghiệp điện ảnh, quá trình dựng hình các hoạt cảnh 3D thường được thực hiện song song trên nhiều máy chủ, giúp giảm thời gian sản xuất và nâng cao chất lượng hình ảnh.

Xử lý trực tuyến cho phép hệ thống tiếp nhận, xử lý và phản hồi dữ liệu liên tục thông qua kết nối mạng. Người dùng có thể tương tác trực tiếp với hệ thống và nhận kết quả gần như ngay lập tức, tạo nền tảng cho các dịch vụ số hiện đại.

Cách xử lý dữ liệu này là yếu tố cốt lõi trong các hệ thống thương mại điện tử, ngân hàng số và các nền tảng dịch vụ trực tuyến.

Ví dụ: Các hệ thống ngân hàng trực tuyến xử lý giao dịch theo thời gian thực, cho phép khách hàng chuyển tiền, thanh toán hóa đơn hoặc tra cứu số dư với dữ liệu luôn được cập nhật.

Xử lý dữ liệu thủ công là hình thức xử lý dựa hoàn toàn vào con người trong các khâu nhập liệu, tính toán và tổng hợp, gần như không có sự hỗ trợ của công nghệ điện tử. Phương pháp này tiêu tốn nhiều thời gian, dễ phát sinh sai sót và khó mở rộng quy mô, nhưng từng giữ vai trò quan trọng trong giai đoạn tiền tin học.

Ngày nay, cách xử lý dữ liệu thủ công chỉ còn tồn tại trong các bối cảnh rất đặc thù hoặc như một bước tạm thời trước khi dữ liệu được số hóa.

Ví dụ: Trước khi hệ thống máy tính phổ biến, các thư viện quản lý dữ liệu sách bằng sổ tay và thẻ mục lục, đòi hỏi thủ thư ghi chép và cập nhật thông tin hoàn toàn bằng tay.

So sánh cách xử lý dữ liệu tự động so với thủ công

Cách xử lý dữ liệu điện tử sử dụng máy tính và các công nghệ kỹ thuật số để thu thập, xử lý, lưu trữ và truyền tải dữ liệu với tốc độ cao và độ chính xác vượt trội. Đây là nền tảng cốt lõi của các hệ thống thông tin hiện đại, cho phép xử lý khối lượng dữ liệu lớn và truy xuất thông tin theo thời gian thực.

Ví dụ: Trong lĩnh vực bán lẻ, hệ thống quét mã vạch tại quầy thanh toán cho phép cập nhật tức thời dữ liệu tồn kho, đồng thời xử lý giao dịch bán hàng chỉ trong vài giây, góp phần nâng cao hiệu quả vận hành và trải nghiệm khách hàng.

Xử lý phân tán là mô hình trong đó các tác vụ tính toán được phân chia và thực hiện đồng thời trên nhiều máy tính hoặc nút mạng khác nhau. Cách xử lý dữ liệu này giúp cải thiện đáng kể hiệu năng, khả năng mở rộng và độ tin cậy của hệ thống, đặc biệt trong các bài toán xử lý dữ liệu quy mô lớn.

Ví dụ: Các nền tảng phát trực tuyến video triển khai xử lý phân tán bằng cách lưu trữ nội dung trên nhiều máy chủ tại các khu vực địa lý khác nhau. Nhờ đó, người dùng có thể truy cập và phát video mượt mà, giảm độ trễ và tránh quá tải hệ thống.

Điện toán đám mây là mô hình cung cấp tài nguyên điện toán như máy chủ, lưu trữ, cơ sở dữ liệu và phần mềm thông qua internet. Mô hình này mang lại khả năng linh hoạt, mở rộng theo nhu cầu và tối ưu chi phí, giúp tổ chức tập trung vào hoạt động kinh doanh cốt lõi thay vì quản lý hạ tầng CNTT.

Ví dụ cách xử lý dữ liệu: Doanh nghiệp nhỏ và vừa có thể sử dụng dịch vụ lưu trữ đám mây và các phần mềm SaaS để vận hành hệ thống thông tin mà không cần đầu tư lớn vào phần cứng, đồng thời dễ dàng mở rộng khi quy mô kinh doanh tăng trưởng.

So sánh giải pháp dựa trên điện toán đám mây so với giải pháp tại chỗ

Cách xử lý dữ liệu tự động ứng dụng phần mềm và các thuật toán để tự động hóa các quy trình xử lý dữ liệu lặp đi lặp lại. Phương pháp này giúp giảm sự can thiệp thủ công, hạn chế lỗi do con người và nâng cao hiệu suất vận hành tổng thể của tổ chức.

Ví dụ: Trong ngành viễn thông, hệ thống lập hóa đơn tự động có khả năng thu thập dữ liệu sử dụng, tính toán chi phí và phát hành hóa đơn định kỳ cho khách hàng, đảm bảo độ chính xác cao và rút ngắn đáng kể thời gian xử lý.

Hệ sinh thái công cụ xử lý dữ liệu ngày càng đa dạng, mỗi nền tảng được thiết kế để tối ưu cho những mục tiêu khác nhau như tốc độ xử lý, khả năng mở rộng, khối lượng dữ liệu lớn hay xử lý theo thời gian thực. Vì vậy, việc lựa chọn đúng cách xử lý dữ liệu không chỉ phụ thuộc vào công nghệ, mà còn gắn chặt với bài toán nghiệp vụ và kiến trúc dữ liệu của tổ chức.

Dù bạn là chuyên viên phân tích dữ liệu, kỹ sư dữ liệu hay người ra quyết định trong lĩnh vực Business Intelligence, việc hiểu rõ vai trò, thế mạnh và giới hạn của từng cách xử lý dữ liệu là nền tảng để xây dựng một hệ thống dữ liệu hiệu quả. Dưới đây là một số công cụ xử lý dữ liệu được sử dụng rộng rãi nhất hiện nay.

Những nguyên tắc về cách xử lý dữ liệu hiện đại không thể được triển khai hiệu quả nếu thiếu một nền tảng phù hợp. Đây chính là khoảng trống mà BCanvas được thiết kế để giải quyết.

BCanvas không chỉ là một công cụ phân tích, mà là một hệ sinh thái xử lý và khai thác dữ liệu hoàn chỉnh, cho phép doanh nghiệp triển khai đúng chuẩn quy trình xử lý dữ liệu hiện đại: tách bạch rõ ràng giữa xử lý dữ liệu và phân tích kinh doanh, đảm bảo dữ liệu được kiểm soát chặt chẽ trước khi phục vụ ra quyết định.

Thông qua Data Rubik, cách xử lý dữ liệu BCanvas giúp doanh nghiệp tự động hóa toàn bộ khâu xử lý dữ liệu: kết nối đa nguồn (Excel, Google Sheets, CRM, phần mềm kế toán, POS…), làm sạch, chuẩn hóa, xử lý ngoại lệ và làm giàu dữ liệu bằng AI. Dữ liệu sau xử lý không chỉ “đúng” về mặt kỹ thuật, mà còn “sẵn sàng” cho phân tích quản trị.

Trên nền dữ liệu đã được chuẩn hóa, các module KPI Map, Phân tích kinh doanh và Hiệu quả tài chính cho phép doanh nghiệp chuyển hóa dữ liệu thành hệ thống chỉ số, dashboard và báo cáo quản trị có chiều sâu. Nhà quản trị không còn phải đọc những con số rời rạc, mà có thể nhìn thấy mối quan hệ nhân – quả giữa các biến số kinh doanh, truy vết chi phí – doanh thu đến từng dòng dữ liệu và ra quyết định dựa trên bản chất thực của hoạt động.

Nói cách khác, BCanvas chính là ví dụ điển hình cho cách xử lý dữ liệu hiện đại được triển khai đúng chuẩn trong thực tiễn doanh nghiệp: dữ liệu được xử lý có kiểm soát, phân tích có cấu trúc và ra quyết định dựa trên hiểu biết sâu sắc, không phải cảm tính.

Phần mềm BCanvas xử lý và phân tích dữ liệu kinh doanh tích hợp AI

Đăng ký trải nghiệm BCanvas ngay hôm nay dành riêng cho mô hình kinh doanh của bạn!

Nhận tư vấn toàn bộ tính năng phần mềm được thiết kế riêng cho doanh nghiệp bạn với sự tư vấn, đồng hành từ đội ngũ chuyên gia chuyên môn sâu.

Apache Spark là một trong những phần mềm xử lý dữ liệu và phân tích dữ liệu lớn mạnh mẽ nhất hiện nay. Cách xử lý dữ liệu này được phát triển chủ yếu bằng Scala, Spark đồng thời cung cấp API cho Python, Java và R, giúp nó trở nên linh hoạt và dễ tiếp cận với nhiều nhóm kỹ thuật khác nhau.

Spark nổi bật nhờ khả năng xử lý tốc độ cao và mở rộng theo chiều ngang, đặc biệt phù hợp với các kiến trúc phân tán. Cách xử lý dữ liệu này tích hợp tốt với Hadoop, Kafka cũng như các dịch vụ đám mây như AWS và Azure. Trong thực tế, Spark thường được triển khai cho các bài toán yêu cầu hiệu năng cao như học máy, xử lý đồ thị, phân tích dữ liệu thời gian thực và xử lý batch quy mô lớn.

Apache Kafka là tiêu chuẩn de facto cho xử lý dữ liệu luồng (streaming) theo thời gian thực. Được xây dựng bằng Java và Scala, Kafka được thiết kế để xử lý các luồng dữ liệu có thông lượng lớn với độ trễ thấp và khả năng chịu lỗi cao.

Kafka đóng vai trò trung tâm trong các kiến trúc hướng sự kiện (event-driven architecture), đặc biệt hiệu quả trong các kịch bản như phát hiện gian lận, giám sát hệ thống, thu thập log và xử lý dữ liệu tức thời. Nhờ khả năng tích hợp chặt chẽ với Spark, Flink, PostgreSQL và các nền tảng đám mây, cách xử lý dữ liệu Kafka thường được lựa chọn khi hệ thống cần phản hồi dữ liệu gần như ngay lập tức.

Microsoft Power BI là phần mềm phân tích dữ liệu và trực quan hóa dữ liệu hàng đầu trong lĩnh vực Business Intelligence. Cách xử lý dữ liệu này cho phép người dùng chuyển đổi dữ liệu đã được xử lý thành các báo cáo và dashboard tương tác, phục vụ trực tiếp cho hoạt động ra quyết định.

Power BI sử dụng cách xử lý dữ liệu DAX và Power Query (M) làm ngôn ngữ cốt lõi, đồng thời có khả năng mở rộng linh hoạt từ nhóm nhỏ đến doanh nghiệp quy mô lớn. Với khả năng tích hợp sâu với Excel, SQL Server, Azure và Google Analytics, Power BI đặc biệt phù hợp để kết nối dữ liệu đa nguồn và trình bày insight một cách trực quan, dễ hiểu cho cả người dùng kỹ thuật lẫn phi kỹ thuật.

Tóm lại, cách xử lý dữ liệu không chỉ là một hoạt động kỹ thuật, mà là nền tảng chiến lược quyết định khả năng khai thác giá trị từ dữ liệu của tổ chức. Trong bối cảnh AI và machine learning ngày càng phát triển, dữ liệu sạch, có cấu trúc và kịp thời chính là điều kiện tiên quyết để đưa ra quyết định chính xác và tạo lợi thế cạnh tranh bền vững trong môi trường số.