ERP

Chuyên ngành

Tools/Apps

Công nghệ

Code riêng

Chất lượng dữ liệu đang dần trở thành yếu tố phân định rõ ràng giữa doanh nghiệp vận hành bằng trực giác và doanh nghiệp ra quyết định bằng thực tế. Trong một môi trường mà dữ liệu được thu thập với tốc độ hàng triệu điểm mỗi ngày, điều quan trọng không còn là “có bao nhiêu dữ liệu” – mà là dữ liệu có đủ tin cậy để dẫn dắt hành động hay không.

Các tổ chức tiên phong đang đầu tư mạnh vào quản trị dữ liệu – thiết lập trung tâm xuất sắc về dữ liệu & phân tích, triển khai cơ chế đo lường chất lượng dữ liệu tại từng điểm chạm. Chỉ khi đảm bảo sự thống nhất, nhất quán và loại bỏ các điểm sai lệch, doanh nghiệp mới có thể xây dựng hệ thống tích hợp dữ liệu mạch lạc, phản ánh trung thực tình hình kinh doanh và tạo cơ sở cho các quyết định kịp thời, đúng trọng tâm.

Trong thực tế, nhiều đội ngũ – đặc biệt là trong bán hàng và tiếp thị B2B – vẫn mắc kẹt trong mô hình “dữ liệu càng nhiều càng tốt”, mà không nhận ra rằng một địa chỉ email sai, một trường dữ liệu lỗi thời hay một phân loại ngành nghề mơ hồ… đều có thể kéo sai toàn bộ chuỗi ra quyết định. Hậu quả là chiến dịch tốn chi phí, chuyển đổi thấp, và năng lực khai thác dữ liệu bị bóp méo một cách hệ thống.

Không có chiến lược dữ liệu nào đủ sức bền nếu chất lượng dữ liệu không được kiểm soát. Trong nhiều doanh nghiệp, các dự án BI (Business Intelligence), CRM, hay phân tích AI thất bại không phải vì công cụ yếu, mà vì dữ liệu đầu vào không đáng tin cậy. Chất lượng dữ liệu không đơn thuần là độ chính xác, mà là mức độ phù hợp, đầy đủ, nhất quán và sẵn sàng để ra quyết định.

Sai lệch ở cấp dữ liệu có thể không nhìn thấy ngay, nhưng hậu quả lại thể hiện rõ ở cấp chiến lược: báo cáo tài chính không khớp với thực tế, các kịch bản dự báo không khả dụng, hay chiến dịch tiếp thị nhắm sai đối tượng. Tệ hơn, sự mất niềm tin vào dữ liệu khiến lãnh đạo quay lại với trực giác – triệt tiêu toàn bộ nỗ lực chuyển đổi số.

Một khảo sát của Gartner từng chỉ ra: chất lượng dữ liệu kém là một trong ba rào cản lớn nhất đối với việc mở rộng phân tích trong doanh nghiệp. Gartner ước tính doanh nghiệp thiệt hại khoảng 12,8 – 12,9 triệu USD/năm do chất lượng dữ liệu kém. Trong khi đó, Precisely – trong khảo sát năm 2025 – cho biết 64% doanh nghiệp tin rằng chất lượng dữ liệu là thách thức lớn nhất mà họ đang đối mặt.

Dữ liệu sai không chỉ gây nhầm lẫn bản thân nó, mà còn tước đi cơ hội tăng trưởng, làm chậm các thiết lập AI/ML và bào mòn niềm tin của lãnh đạo vào hệ thống ra quyết định.

Đằng sau những con số này là một sự thật không dễ đối mặt: nhiều doanh nghiệp vẫn thu thập dữ liệu như một “thói quen công nghệ”, mà chưa xây dựng hệ thống đánh giá và cải thiện chất lượng dữ liệu một cách liên tục. Dữ liệu được trích xuất từ nhiều hệ thống khác nhau nhưng không có chuẩn hóa, không có quy trình kiểm định, không ai chịu trách nhiệm về “sự toàn vẹn” của dữ liệu.

Một hệ thống phân tích mạnh không thể tồn tại trên nền dữ liệu yếu. Ngược lại, khi chất lượng dữ liệu được đảm bảo – thông qua quy trình Data Governance, Data Stewardship, và các chỉ số đo lường rõ ràng – doanh nghiệp không chỉ tối ưu được hiệu suất vận hành, mà còn mở ra năng lực học máy, dự báo, và phân tích thời gian thực một cách hiệu quả.

>> Tham khảo dòng giải pháp phần mềm phân tích kinh doanh BCanvas – một nền tảng được thiết kế dành riêng cho các doanh nghiệp đang tìm kiếm sự đột phá trong quản trị bằng dữ liệu. BCanvas không chỉ giúp tháo gỡ tận gốc những rào cản khi triển khai hệ thống báo cáo nội bộ mà còn kiến tạo một nền tảng quản trị linh hoạt, mạnh mẽ và đủ độ sâu để dẫn dắt chiến lược dài hạn.

BCanvas không chỉ xử lý dữ liệu – mà cấu trúc lại toàn bộ quy trình ra quyết định. Với khả năng liên kết dữ liệu từ nhiều phòng ban – từ marketing, tài chính đến vận hành – BCanvas tạo nên một bức tranh quản trị thống nhất, cập nhật theo thời gian thực, giàu ngữ cảnh và luôn sẵn sàng để hành động– từ đó xây dựng một hệ quy chiếu chung giữa dữ liệu, hành động và chiến lược.

Điểm khác biệt của BCanvas không chỉ là công nghệ – mà là tư duy nền tảng: giúp doanh nghiệp từng bước chuyển hóa dữ liệu từ dạng “thông tin kỹ thuật” thành “năng lực tổ chức”. Từ đó, hình thành một văn hóa dữ liệu trưởng thành, nơi dữ liệu marketing không chỉ đo lường hiệu quả, mà định hình tương lai – tạo nên lợi thế cạnh tranh bền vững trong một thị trường đang chuyển động từng giờ.

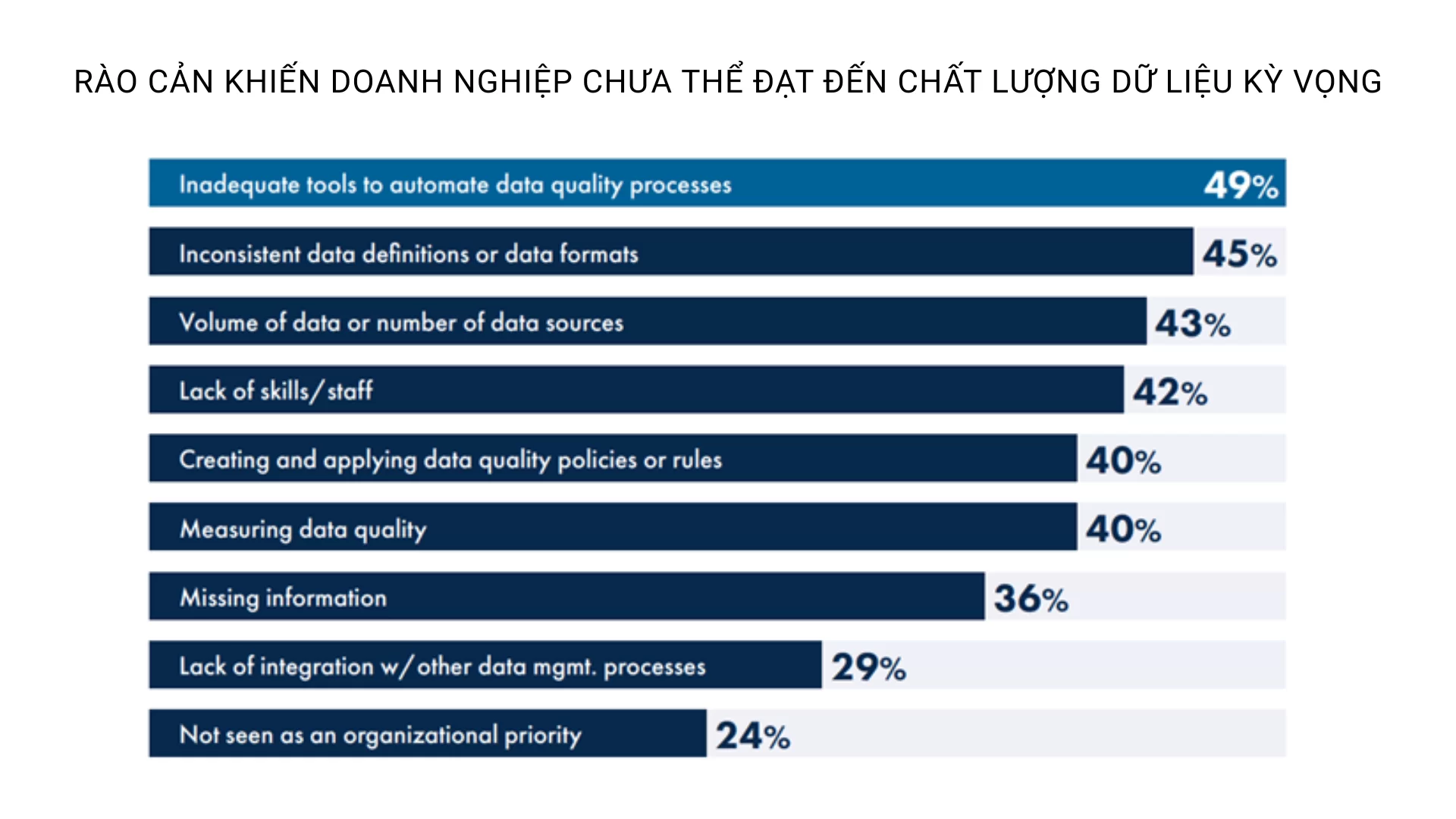

Mặc dù dữ liệu được xem là tài sản chiến lược, nhưng trên thực tế, phần lớn doanh nghiệp vẫn chưa thể kiểm soát được chất lượng dữ liệu ở mức như mong muốn. Theo báo cáo khảo sát, có tới 77% tổ chức tự đánh giá chất lượng dữ liệu của họ chỉ ở mức trung bình hoặc thấp, tăng đáng kể so với con số 66% vào năm trước – cho thấy xu hướng tuột dốc thay vì cải thiện trong năng lực quản trị dữ liệu.

Việc quản lý chất lượng dữ liệu vẫn còn phụ thuộc nhiều vào thao tác thủ công hoặc các công cụ rời rạc, khiến các quy trình kiểm tra – chuẩn hóa – phát hiện lỗi trở nên cồng kềnh và không đồng nhất. Trong bối cảnh dữ liệu đổ về liên tục từ nhiều hệ thống, sự thiếu hụt tự động hóa không chỉ làm chậm phản ứng mà còn làm sai lệch kết quả phân tích.

Một trong những rào cản lớn nhất hiện nay là không có sự thống nhất trong định nghĩa dữ liệu giữa các phòng ban. Ví dụ: “khách hàng” trong bộ phận bán hàng có thể là người đã đăng ký, nhưng trong tài chính lại phải là người đã thanh toán. Việc thiếu khung quản trị dữ liệu tập trung khiến các hệ thống “nói chuyện không cùng ngôn ngữ”, tạo ra sự sai lệch ngay từ gốc.

Tốc độ tăng trưởng dữ liệu đang vượt xa tốc độ đầu tư vào năng lực quản trị dữ liệu. Việc thu thập dữ liệu ngày càng đa nguồn, đa định dạng – từ giao dịch khách hàng đến cảm biến IoT – khiến các doanh nghiệp nhanh chóng bị “ngộp” nếu không có chiến lược hạ tầng phù hợp như kho dữ liệu, hồ dữ liệu hoặc kiến trúc lakehouse.

Mặc dù phải đối mặt với nhiều rào cản, điều đáng khích lệ là 60% tổ chức được khảo sát đã xác định chất lượng dữ liệu là ưu tiên hàng đầu trong chiến lược đảm bảo toàn vẹn dữ liệu. Điều này phản ánh sự thay đổi nhận thức rõ rệt: từ chỗ coi dữ liệu chỉ là nguyên liệu thô, sang xem dữ liệu là năng lực cốt lõi để cạnh tranh trong kỷ nguyên AI và ra quyết định theo thời gian thực.

Những tổ chức dẫn đầu đang tập trung vào:

Trong kỷ nguyên dữ liệu, chất lượng dữ liệu là năng lực chiến lược của tổ chức. Một hệ thống dữ liệu dù có quy mô lớn hay kiến trúc hiện đại đến đâu cũng sẽ trở nên vô nghĩa nếu dữ liệu bên trong thiếu độ tin cậy. Dữ liệu chất lượng thấp không chỉ làm sai lệch các phân tích, mà còn trực tiếp ảnh hưởng đến vận hành, chăm sóc khách hàng và ra quyết định chiến lược.

Dưới đây là 6 yếu tố CỐT LÕI tạo nên một hệ thống dữ liệu chất lượng – nền tảng giúp doanh nghiệp ra quyết định đúng, kịp thời và có tác động thực sự.

Dữ liệu phải phản ánh đúng thực tế mà nó đại diện – từ thông tin khách hàng, mã sản phẩm, đến số liệu giao dịch. Độ chính xác không chỉ phụ thuộc vào nguồn cấp, mà còn phụ thuộc vào quá trình nhập liệu, xử lý và chuẩn hóa.

Một địa chỉ sai có thể khiến đơn hàng không đến nơi. Một sai lệch nhỏ trong báo cáo doanh thu có thể khiến nhà đầu tư mất niềm tin.Trong các hệ thống ERP, CRM hay kho dữ liệu hiện đại, việc tích hợp xác thực dữ liệu ngay từ đầu nguồn là yếu tố sống còn để bảo vệ tính chính xác.

Khi một khách hàng có hai tên khác nhau trong hệ thống CRM và hệ thống bán hàng – điều gì sẽ xảy ra? Những mâu thuẫn nhỏ như vậy có thể tạo ra sai lệch lớn trong các mô hình phân tích và dự báo. Tính nhất quán đảm bảo mọi bộ phận trong doanh nghiệp “nhìn thấy một sự thật duy nhất” – không có xung đột giữa các phiên bản dữ liệu.

Dữ liệu chỉ có giá trị khi nó tuân thủ các quy tắc nghiệp vụ đã được định nghĩa rõ ràng: định dạng email phải đúng, số điện thoại phải hợp lệ theo khu vực, chỉ số KPI không được âm… Các công cụ quản lý chất lượng dữ liệu hiện đại cho phép tạo bộ quy tắc kiểm tra ngay trong pipeline, giúp hệ thống tự động phát hiện và loại bỏ những dữ liệu không hợp lệ ngay từ điểm đầu vào.

Một hồ sơ khách hàng thiếu địa chỉ email, một bản ghi giao dịch thiếu thông tin chi nhánh – đó là những ví dụ của dữ liệu không đầy đủ, và chúng có thể khiến các chiến dịch phân tích hoặc tự động hóa thất bại.

Tính đầy đủ không chỉ dừng ở việc có đủ cột dữ liệu, mà còn bao gồm cả siêu dữ liệu – thông tin về nguồn, thời điểm, trạng thái và chất lượng của dữ liệu. Đây là cơ sở để xây dựng hệ thống truy xuất nguồn gốc và đánh giá độ tin cậy phân tích.

Không có dữ liệu nào là giá trị nếu nó đến quá muộn. Trong môi trường kinh doanh thời gian thực, khả năng cập nhật dữ liệu kịp thời chính là yếu tố quyết định sự sống còn – đặc biệt trong quản lý rủi ro, cảnh báo tài chính hoặc tối ưu chuỗi cung ứng.

Các hệ thống hiện đại sử dụng kiến trúc streaming data hoặc ETL/ELT tự động theo lịch trình thông minh, giúp đảm bảo dữ liệu luôn sẵn sàng để phân tích và ra quyết định.

Không có bản ghi trùng lặp. Mỗi đối tượng – khách hàng, sản phẩm, giao dịch – phải được định danh duy nhất. Việc lặp dữ liệu không chỉ khiến báo cáo sai lệch, mà còn gây lãng phí tài nguyên hệ thống và ảnh hưởng đến trải nghiệm khách hàng.

Xem thêm:

Chất lượng dữ liệu giờ đây có thể gắn liền với khả năng phân tích, ra quyết định và tự động hóa quy trình trong doanh nghiệp hiện đại. Trong bối cảnh dữ liệu tăng theo cấp số nhân và ngày càng phân tán, công nghệ không chỉ giúp “phát hiện lỗi”, mà còn thiết kế lại cách tổ chức tiếp cận và duy trì chất lượng dữ liệu một cách chủ động, liên tục và có hệ thống.

Thay vì kiểm tra chất lượng thủ công sau khi dữ liệu đã đi vào báo cáo, doanh nghiệp hiện đại đang chuyển sang thiết lập các điểm kiểm soát ở ngay đầu nguồn. Các thuật toán kiểm tra định dạng, logic nghiệp vụ, tính đầy đủ và độ trùng lặp được tích hợp trực tiếp vào pipeline xử lý dữ liệu – giúp phát hiện vấn đề ngay tại thời điểm phát sinh.

Điều này không chỉ giảm thiểu sai sót, mà còn giúp doanh nghiệp phản ứng kịp thời với sự cố chất lượng dữ liệu, trước khi chúng ảnh hưởng đến phân tích và ra quyết định.

Với khối lượng dữ liệu lớn và phức tạp, doanh nghiệp khó có thể liệt kê trước mọi quy tắc kiểm tra. Vì vậy, một hướng đi đang được áp dụng là phân tích hành vi dữ liệu theo thời gian – nhận diện những mẫu giá trị bất thường, những thay đổi bất ngờ về phân phối hoặc định dạng.

Cách tiếp cận này không dựa vào tên công cụ, mà dựa vào năng lực thiết kế hệ thống đủ linh hoạt để học và phản hồi lại sai lệch dữ liệu. Điều này đặc biệt hữu ích trong môi trường có nhiều nguồn dữ liệu, thay đổi thường xuyên hoặc chưa có quy chuẩn rõ ràng.

Xem thêm:

Một xu hướng được áp dụng nhiều trong các doanh nghiệp có hệ thống phân tích phức tạp là triển khai vùng sandbox riêng biệt cho phân tích và thử nghiệm. Điều này giúp đảm bảo hệ thống báo cáo chính thức không bị ảnh hưởng bởi những thay đổi dữ liệu chưa được kiểm định, đồng thời tạo điều kiện cho việc cải tiến liên tục mà vẫn giữ được độ tin cậy tổng thể.

Chất lượng dữ liệu vì thế không phải là trạng thái – mà là một dòng chảy sống động, luôn cần được theo dõi và duy trì.

Chất lượng dữ liệu không nên chỉ đo bằng các chỉ số kỹ thuật (như % dữ liệu thiếu hoặc sai), mà cần gắn trực tiếp với hệ quả kinh doanh:

Doanh nghiệp có thể triển khai dashboard chất lượng dữ liệu gắn với chỉ số vận hành – giúp ban lãnh đạo thấy rõ chi phí vô hình của dữ liệu kém và thúc đẩy đầu tư đúng mức cho cải thiện.

Cuối cùng, một xu hướng quan trọng là đưa chất lượng dữ liệu vào thiết kế hệ thống ngay từ đầu. Thay vì “sửa lỗi sau”, doanh nghiệp cần đặt ra yêu cầu về chất lượng trong mọi giai đoạn – từ thu thập, lưu trữ, xử lý đến truy xuất dữ liệu.

Kiến trúc hiện đại không chỉ là câu chuyện của tốc độ và quy mô – mà còn là khả năng duy trì tính toàn vẹn dữ liệu trong suốt vòng đời sử dụng. Đây là yếu tố nền tảng để doanh nghiệp tiến tới khai thác AI, phân tích nâng cao hay tự động hóa quy trình một cách đáng tin cậy.

TacaSoft,